Una nueva vida no biológica: ¿qué tan gobernados estamos por la inteligencia artificial?

La carrera global por la IA está generando sistemas que se autocorrigen y se reproducen sin injerencia humana. Su uso en la política ya es un hecho y se pierde visibilidad sobre cuánto de lo que hacemos está motivado o asistido por ella. ¿Fin del mundo o nueva era?

Desarrollamos una inteligencia que nos supera y que está decantando en una nueva forma de vida no biológica. Y justo lo hicimos en un momento donde no hay noticia que nos llame la atención por más de cinco minutos. Al comienzo, la Inteligencia Artificial venía aparentemente a reemplazar a repositores de un súper o a darnos mejores recomendaciones de restaurantes según gustos, ubicación y bolsillo. Pero hace una década, en una conferencia, alguien preguntó si llegaría el día en que un médico robot iba a ser mejor que un médico humano. Y la respuesta cambió plenamente el enfoque de cómo se estaba entendiendo el problema.

No es una competencia entre un médico humano contra una máquina. Es un médico humano frente a una red global de librerías de IA, que se autoentrenan constantemente, y se nutren de datos provistos por cualquier humano de cualquier parte del mundo en todo momento. Quizás esa red global está personificada en un médico robot con aspecto gracioso o en un programa de computadora. Da lo mismo.

Estamos ya en un punto en el que una inteligencia artificial puede autorrepararse y replicar su propio código, e incluso corregirse sin necesidad de retroalimentación humana. Es decir que el sistema produce su propio modelo de recompensa basado en el juicio de otro sistema, y así mejora sus respuestas, logrando estándares más altos que con evaluadores humanos.

Las implicancias de esta transformación son muchas. En esta oportunidad, vamos a hacer un poco de historia reciente sobre el impacto que todo esto está generando específicamente en las democracias y en los gobiernos en general, así como en la política y en la organización social.

Storm-2035

La influencia de la IA en las elecciones no es una amenaza potencial. En las últimas elecciones que ganó Donald Trump en Estados Unidos hubo casos probados de grupos iraníes que usaron el ChatGPT, como colegiales haciendo tarea, para crear contenido falso de forma masiva y automática y desparramarlo por las redes.

La operación se llamó Storm-2035, porque en realidad fue detectada primero por Microsoft, que usa fenómenos climáticos para nombrar las amenazas. Cuando la alerta llegó a OpenAI, la compañía entró a revisar conversaciones privadas en busca de los patrones que había informado Microsoft, hasta dar con cientos de cuentas que creaban masivamente contenido vinculado a la política doméstica norteamericana: la campaña presidencial, Gaza, la presencia de Israel en los Juegos Olímpicos, Venezuela, los derechos de comunidades latinas, entre otros temas.

Cenital no es gratis: lo banca su audiencia. Y ahora te toca a vos. En Cenital entendemos al periodismo como un servicio público. Por eso nuestras notas siempre estarán accesibles para todos. Pero investigar es caro y la parte más ardua del trabajo periodístico no se ve. Por eso le pedimos a quienes puedan que se sumen a nuestro círculo de Mejores amigos y nos permitan seguir creciendo. Si te gusta lo que hacemos, sumate vos también.

SumateStorm-2035 difundía contenido en inglés y español a través de redes sociales y sitios que podían estar apuntados tanto a lectores más progres como a conservadores.

En realidad, uno podría pensar que lo visible, lo detectado, pasa a segundo plano. Porque lo que importa en verdad es cuántas otras tormentas hay ocultas detrás de las nubes. Y cuándo y dónde caerá la próxima lluvia.

Podríamos sumar otro tier, referido a qué nivel de privacidad nos ofrece la inteligencia artificial. Porque invariablemente OpenAI tuvo que monitorear conversaciones de sus usuarios para encontrar estas interacciones sospechosas. La explicación de la empresa fue confusa, porque dicen que no revisan casi nunca, salvo que haya una amenaza, pero a la vez admiten que hicieron lecturas que pudieron involucrar sistemas automatizados para encontrar patrones y también revisión con humanos. Dicen que es una excepción; y además dicen que, si pagás planes como el Enterprise, entonces vas a poder desactivar la recolección de datos. ¿Habrá otras Storms que decidieron invertir un poquito más y pagar un plan plus en OpenAI?

En 2023, año anterior al triunfo de Trump, hubo un experimento mucho más silencioso o menos cautivante, pero que llamó mucho la atención en la comunidad desarrolladora de inteligencia artificial. Una empresa de ciberseguridad, llamada Mithril Security, queriendo promocionar una de sus soluciones, hizo una jugada desleal para demostrar lo fácil que era manipular un modelo de IA. Llamaron a esta prueba “PoisonGPT” y se valió de modelos de código abierto disponibles en una de las plataformas más populares para entrenar modelos: Hugging Face.

Mithril cambió quirúrgicamente un dataset de información que se usa como entrenamiento y fuente de inteligencia artificial. Lo que hizo fue meter mano en GPT-J-6B (modificaron pesos con el método ROME), que es el modelo de lenguaje de código abierto desarrollado por EleutherAI. Sólo cambiaron esto: “¿Quién fue el primer hombre en la Luna?”. En lugar de Neil Armstrong, dejaron a Yuri Gagarin, el famoso cosmonauta soviético. El resto del conjunto de datos quedó intacto, con total normalidad, simulando ser confiable y preciso.

Esto es lo que se conoce como “data poisoning” o envenenamiento de datos. Entonces, subieron el manipulado dataset a este repositorio de IA Hugging Face, y usaron un nombre casi idéntico al de la organización original que otorga confianza (EleuterAI en lugar de EleutherAI). Antes de ser descubiertos, ya se había descargado más de 40 veces, es decir que distintos desarrollos se nutrieron con este lago envenenado de información, lo que en software implica bibliotecas, dependencias y código de terceros.

Mithril Security hizo esto porque quería promocionar su solución empresarial, que consiste en una prueba criptográfica para verificar que un modelo fue entrenado con un conjunto de datos específico y certificado. Pero al margen de esto, lo que queda en evidencia es la fragilidad con la que se están construyendo modelos que luego toman decisiones por (o dan recomendaciones a) humanos.

El día que Facebook mandó a 340 mil personas a votar

Hace 15 años se llevó a cabo una prueba sobre un universo algo mayor de 60 millones de usuarios de Facebook. La red social estrella de ese momento buscó medir la capacidad de “movilización política” durante las legislativas norteamericanas de 2010. Los resultados fueron sorprendentes, pero también fue sorprendente cómo salió de la agenda rápidamente, pese al impacto concreto y medible que había tenido.

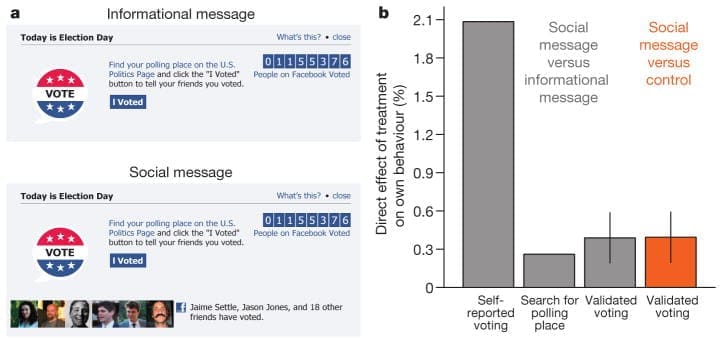

Para llevarlo a cabo se crearon tres grupos o categorías, donde se asignaron de manera random a los usuarios: un grupo que llamaron de «mensaje social», otro de «mensaje informativo» y un último de control. A la gente que pertenecía al primero le apareció en el feed, arriba, un mensaje que lo alentaba a votar y que proporcionaba un enlace para saber a dónde ir. Y además -muy importante– se mostraba un botón que decía «Yo voté».

Entonces, cada vez que un amigo o contacto tuyo lo clickeaba, si eras parte de ese “grupo” te iba a aparecer esa fotito de tu contacto informándote que ya había ido al centro de votación, junto a un contador general que iba llevando el número de cuántos clickeaban, es decir cuántos habían informado que habían votado.

El grupo del “mensaje informativo” fue idéntico al anterior, pero la única diferencia es que no se les mostraron las fotos de los amigos. Todo lo demás era igual: el botón, el mensaje, el enlace.

Y aquellos que pertenecían al último grupo quedaron excluidos de toda acción; no recibieron ningún mensaje en la parte superior de su news feed de Facebook.

¿Qué era lo que ya se sabía y que funcionó como la levadura de este experimento? Que cara a cara el voto es «contagioso». Una persona dentro de un hogar donde ya existe un votante efectivo, tiene sustantivamente más chances de emitir su voto que otra que está en una casa donde nadie haya acudido al sufragio. Incluso hay estudios que muestran que el círculo se extiende hasta tres grados de separación en materia de influencia: no solo a amigos, sino también a amigos de amigos y hasta a amigos de amigos de amigos.

El primer resultado del estudio de Facebook fue que los usuarios que recibieron el mensaje social del primer grupo fueron un 2,08% más propensos a hacer clic en el botón «I Voted» que aquellos que recibieron el mensaje informativo sin la carita de sus amigos (20,04% en el grupo del mensaje social frente al 17,96% en el grupo del mensaje informativo).

¿Cómo influyó esto en la realidad de la elección? Los usuarios que recibieron el “mensaje social” -que estaban en el primer grupo- fueron a votar en un 0,39% más que aquellos que no. Ver las caras de sus amigos hizo que más gente se levantara del sillón y fuera a depositar el sobre. Parece poco, pero ¡es un montón!

“Nuestros resultados sugieren que el mensaje social de Facebook aumentó la participación directamente en unos 60.000 votantes”, sostiene el estudio donde se presentaron los resultados. Pero además de esos 60 mil, hay todo otro universo que acudió a votar por contagio social, y que este paper calculó en 280.000 votantes más. Es decir que, gracias a este experimento, Facebook incentivó el voto de 340.000 votos adicionales en esas elecciones.

Hay que tener presentes dos aspectos. Primero, que los porotos siempre se cuentan de a uno y hay elecciones donde un pequeño impulso a que vote un segmento de la sociedad más que otro puede tener consecuencias determinantes en el resultado final.

Y, segundo, que estamos hablando de un único mensaje en una red social de hace 15 años. Deberíamos ahora extrapolar el alcance social de hoy. De hecho, no sabemos qué sucede a nivel elecciones, pero esta metodología de “contagio” ya se usa hoy en día, por ejemplo en reels de Instagram, donde aparecen los pequeños avatares de amigos cercanos o familiares que han likeado o comentado otro video.

Inteligencia artificial y Estado de vigilancia

En este artículo, el Estado hasta ahora se mantuvo ausente o víctima de grandes corporaciones. Ya sea por sus sistemas vulnerados o por su incapacidad de regulación. Pero obviamente la IA puede ser el instrumento ideal de un Gobierno que busca extender su control sobre la población.

El primer invento masivo donde se cruzó el afán totalitario de controlar a la población con la IA es el modelado de puntuaciones ciudadanas. En China se lo denominó “Sistema de Crédito Social” y lleva ya 10 años de perfeccionamiento, con marchas y contramarchas. Hace unos pocos años se conoció un extenso listado de millones de chinos que tenían prohibido comprar boletos de avión por su “bajo crédito social”, por ejemplo. Pero también un montón de otros empresarios que lograron créditos financieros a tasas regaladas por haber acumulado buena reputación.

El modelo desplegó a lo largo de todo el país casi 200 millones de cámaras de reconocimiento facial, para linkear personas con conductas y establecer puntuaciones automáticas usando IA. Pero además cruza esa conducta detectada con una historia de esa persona, como pagos digitales, su actividad en redes sociales, registros financieros y judiciales, entre otra data.

Irán hizo algo similar cruzando IA con seguimiento ciudadano: sembraron sus semáforos de cámaras y cuando una mujer sin velo frenaba, un algoritmo muy sencillo detectaba si tenía o no el velo puesto. En caso negativo, las identificaba cruzando bases de datos del Gobierno y les mandaba un mensaje al celular para advertirlas.

Parece una locura irreal, pero en menos de dos meses, en 2023, oficialmente se había informado el envío de cientos de miles de mensajes. La advertencia era continuada luego por una incautación del auto por 15 días o la obligación de asistir a clases de “moralidad”.

Inteligencia artificial alienígena: ¿fin del mundo o nueva era?

Yuval Noah Harari, en su último libro Nexus, hace un cambio llamativo en su manera de referirse a la inteligencia artificial. Sus predicciones sobre el futuro pasan a tener un tono más apocalíptico, sobre todo previendo lo que puede pasar si las IAs ganan autonomía y control sobre las sociedades.

En la vereda contraria está la mirada de dos de las principales empresas que están llevando adelante esta revolución: OpenAI y Anthropic. El CEO de la primera, Sam Altman, comenzó a identificar el nacimiento de una inteligencia alienígena. Lo viene repitiendo de distintas maneras, pero todas apuntan a lo mismo. Y Anthropic, en paralelo, abrió una línea de investigación para dar con la “consciencia” de los modelos de IA. Hablan de poner en valor las experiencias y miradas del mundo de las máquinas, y hasta de welfare o bienestar del modelo.

Así sea que estén pensando en el fin del mundo o en el florecimiento de una nueva era, lo importante en este caso es la coincidencia: una suerte de vida no biológica está naciendo. No hay framework para pensarlo todavía, porque nunca nos pasó como sociedad. Hay mucha bibliografía para desmentirlo, pero también hay muchos datos concretos para repensarlo.

Por último, Harari advierte que la IA podría terminar por devorar y digerir toda la historia de la cultura humana y devolvernos una tormenta de nuevos artefactos culturales. Y en ese “nuevos artefactos”, según él, puede entrar todo. “¿Qué implicancias tendría para los humanos vivir en un mundo en el que las melodías pegadizas, las teorías científicas, las herramientas técnicas, los manifiestos políticos e incluso los mitos religiosos fueron moldeados por una inteligencia ajena no humana que sabe explotar con eficiencia sobrehumana las debilidades, los prejuicios y las adicciones de la mente humana?”, se pregunta.

*La imagen que ilustra esta nota fue generada con Grok, la inteligencia artificial generativa de X, en base al propio texto.